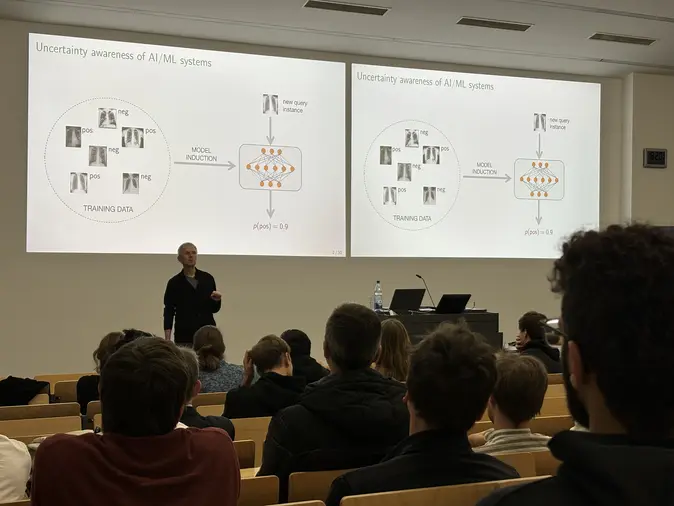

Lectures: Unsicherheitquantifizierung beim Maschinellen Lernen

Wir das Privileg, Prof. Dr. Eyke Hüllermeier zu einem spannenden und aufschlussreichen Vortrag über die Unsicherheitsq-Quantifizierung beim Maschinellen Lernen zu empfangen. Ein großes Dankeschön an Prof. Hüllermeier dafür, dass er seine Expertise geteilt und interessante Diskussionen rund um dieses wichtige Thema angeregt hat.

Warum ist die Quantifizierung von Unsicherheiten wichtig? Wie Prof. Hüllermeier betonte, ist das Verständnis und der Umgang mit Unsicherheiten in der KI der Schlüssel zum Aufbau vertrauenswürdiger und robuster Modelle für Maschinelles Lernen. Dies ist besonders wichtig bei sicherheitskritischen Anwendungen wie autonomem Fahren und medizinischer Diagnose, bei denen die Kosten von Fehlern erheblich sein können.

Er erläuterte zwei Hauptarten von Unsicherheiten beim maschinellen Lernen:

- Aleatorische Unsicherheit: Aufgrund der inhärenten Zufälligkeit im Datengenerierungsprozess kann diese Art von Unsicherheit nicht reduziert werden. Wenn zum Beispiel die Sicht aufgrund von Schnee schlecht ist, ist es unmöglich, Verkehrsschilder genau zu interpretieren.

- Epistemische Unsicherheit: Sie entsteht aus dem Mangel an Wissen oder Kapazität des Modells. Wenn es sich z. B. um ein unbekanntes Verkehrsschild handelt, kann es vom Modell nicht richtig erkannt werden. Diese Unsicherheit kann oft mit mehr Daten oder besseren Modellen reduziert werden.

Zentrale Erkenntnisse der Arbeitsgruppe von Prof. Hüllermeier in diesem Zusammenhang:

- Eine Literaturranalyse zu Unsicherheit im Maschinellen Lernen zeigt die Relevanz dieses Themas und mehrerer Ansätze: https://link.springer.com/article/10.1007/s10994-021-05946-3

- In einer kürzlich durchgeführten Studie fanden sie heraus, dass der Evidential Deep Learning-Ansatz die epistemische Unsicherheit nicht quantifizieren kann, da es keine geeignete Bewertungsregel (proper scoring rule) gibt, die auf ihren Annahmen basiert: https://proceedings.mlr.press/v235/juergens24a.html

Dieser Vortrag war eine wunderbare Erinnerung an den Wert der Unsicherheitsquantifizierung für die Gewährleistung der Zuverlässigkeit von KI-Systemen. Es geht nicht nur darum, genaue Vorhersagen zu treffen, sondern auch darum, zu wissen, wann man diesen Vorhersagen vertrauen kann.

Ein großes Dankeschön an alle, die teilgenommen und zu den zum Nachdenken anregenden Diskussionen beigetragen haben. Lassen Sie uns weiter untersuchen, wie wir Unsicherheiten angehen können, um robustere KI-Modelle zu schaffen.